В докладе рассматриваются кейсы использования искусственного интеллекта с Loginom для решения различных задач. Специфика работы больших языковых моделей с Loginom, структуризация и классификация нормативно-справочной информации, автодокументирование и генерация кода. Использование ИИ для автоматизации работы с данными.

Искусственный интеллект (ИИ) — одна из самых «горячих» тем в информационных технологиях. Понятие ИИ, в связи с ростом его популярности, применяют ко всему подряд: от микроволновки до базы данных. Перед тем, как говорить о кейсах и подходах к внедрению систем, основанных на ИИ, необходимо определиться с терминологией.

Под ИИ уместно понимать большие языковые модели (LLM). Именно они обладают особыми эмерджентными свойствами, которые принципиально отличают LLM от любых других нейросетевых моделей. Большие языковые модели не просто решают задачу генерации токенов, на которой их обучали, а имеют знания и навыки их применения, позволяющие решать сложные задачи.

Системы на базе LLM отличаются тем, что значительная часть логики заменяется промптингом — обычным текстом на человеческом языке. Свойства, которые выделяют LLM из множества других моделей:

Из перечисленных свойств необходимо выделить универсальность и стохастичность. В одних задачах (например, создание текстов или изображений) LLM дают потрясающие результаты. В других — имеют существенные недостатки, так как универсальный инструмент часто уступает специализированному. Важно учитывать это при построении систем с ИИ.

Работа с ИИ в Loginom реализуется посредством использования Компонента REST-запрос. Важно: сервер, который обслуживает запросы к LLM, — это всегда внешний компонент. Однако к настоящему времени их разработали достаточно много: llama.cpp, Ollama, vLLm, GPU Stack и др. Установить и настроить их относительно просто, главное иметь мощный сервер с GPU.

Для работы с внешними сервисами по REST API рекомендуется создавать отдельный Сценарий Loginom, который затем подключается по ссылке к «боевому» Сценарию пользователя. Такие Сценарии называются «коннекторами».

Создавать их несложно, важно изучить документацию внешнего сервиса, чтобы понять, в каком виде направлять запросы и в каком виде придут ответы. Как правило, форма ответа немного меняется в зависимости от того, запрос был обработан успешно или с ошибкой.

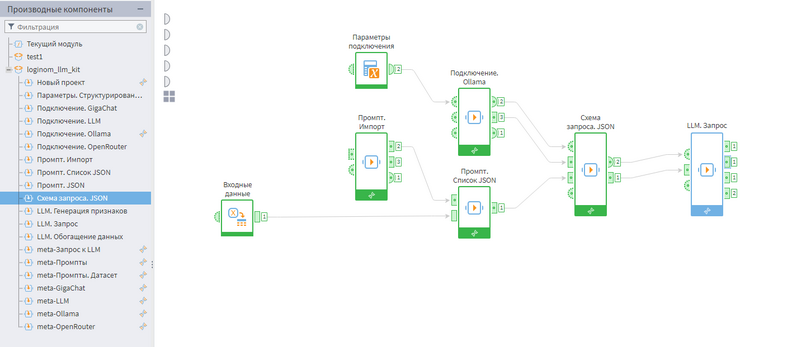

Loginom LLM Kit — библиотека для работы с LLM сервисами

Опубликовано готовое решение для работы с LLM: Loginom LLM Kit. На сайте есть развернутое описание библиотеки. Loginom LLM Kit содержит множество компонентов для организации эффективной работы с ИИ:

Таким образом, пользователям не придется создавать свои собственные коннекторы. Как всегда, библиотека подробно документирована и распространяется свободно.

Важный момент: отличие корпоративного использования от индивидуального. Loginom может быть применен в обоих случаях. Корпоративные системы существенно сложнее индивидуальных, даже при реализации схожего функционала. Это объясняется необходимостью обеспечения корпоративных требований к информационным системам по безопасности, отказоустойчивости, масштабированию, логированию и хранению результатов.

Когда систему используют тысячи пользователей каждый день, обязательно возникнут ситуации, которые разработчики не предусмотрели. При этом критически необходимо минимизировать возникающие риски, а также выяснить и устранить причину проблемы.

Поэтому, внедряя ИИ в корпоративные процессы, всегда нужно помнить об этих фундаментальных различиях.

Возникает вопрос: может ли текущий ИИ заменить системы корпоративного или индивидуального применения. Ведь на фоне бума ИИ повестку дня просто переполнили материалы под лозунгами:

Может показаться: «Почему нет?», «Может быть, уже пора?». Цель понятна: можно радикально сократить расходы.

Но, к сожалению, нет. Не получится. Любая информационная система корпоративного уровня хранит в себе уникальную экспертизу множества специалистов. Только они знают, как в компании все устроено, как организовано взаимодействие, какие есть нюансы и исключения. Даже сверхинтеллекту будет непросто в этом разобраться, а его пока не создали.

Текущий ИИ, каким бы мощным он ни был, пока не способен полностью заменить эту глубокую, специфическую экспертизу. Он не может с полуслова понять все детали бизнес-процессов и выдать именно тот результат, который мы ожидаем.

Поэтому в ближайшее время по-прежнему придется создавать системы и сценарии обработки данных, привлекая ИИ лишь на отдельных этапах — там, где он действительно эффективен и приносит максимальную пользу.

Структуризация нормативно-справочной информации (НСИ) — это типовая задача обработки текстовых данных. На вход подается набор описаний товарно-материальных ценностей (ТМЦ) или иных объектов. Особенность в том, что эта информация не структурирована: все содержится в нескольких предложениях.

Чтобы иметь возможность эффективно решать бизнес-задачи, такие как поиск аналогов, дедубликация, подбор по параметрам и т.п., необходимо выполнить структуризацию. То есть, отнести каждую запись к одному или нескольким классам, определить для нее значения требуемых атрибутов.

Схема работы дуговой плавильной печи

Консалтинг Loginom Company достаточно давно занимается этой задачей. С 2023 года были испробованы, вероятно, все актуальные способы ее решения: от классических классификаторов и парсеров на основе правил до ИИ.

И применение ИИ дает неплохие результаты. Во-первых, можно использовать простые решения по обогащению данных. Часто в исходном описании ТМЦ содержится недостаточно данных для определения всех атрибутов. Что делает в такой ситуации обычный пользователь? Начинает поиск в интернете.

Эту операцию может выполнить специализированный поисковый сервис, который не просто выдаст список релевантных результатов, но и приготовит резюме на их основании. Остается лишь подготовить и отправить запрос к такому сервису в своем Сценарии. Весьма полезно предусмотреть возможность кеширования, т.к. обычно такие сервисы платные.

Во-вторых, ИИ можно использовать для решения задачи классификации НСИ. Вместо обучения и использования собственных ML-моделей, можно сформировать запрос к LLM с просьбой отнести запись ТМЦ к одному из нескольких классов.

Классификация НСИ

Разумеется, у такого подхода есть подводные камни:

Но при должной усидчивости за счет доведения системы запросов и промптов можно получить отличный результат. Также важно использовать качественный классификатор. Например, распределить что-то по группам с использованием Общероссийского классификатора продукции по видам экономической деятельности (ОКПД) или Каталога товаров, работ, услуг для обеспечения государственных и муниципальных нужд (КТРУ) даже человеку очень непросто.

В-третьих, возможно решение задачи определения значений атрибутов с использованием LLM. Все, что было сказано выше относительно классификации, справедливо и здесь. Но задача более сложная: каждая связка «класс-атрибут» обладает своей спецификой, которую нужно «донести» до LLM.

В этом случае весьма полезен так называемый подход Few-Shot: когда дополнительно к инструкциям в запрос включаются несколько примеров разбора ТМЦ на атрибуты. Для каждого класса нужно подготовить такие примеры и динамически подставлять их в запрос.

Преимущества подхода: легкая реализация, быстрое прототипирование, типовой паттерн для всех задач, настройка на естественном языке, смена модели на более современную улучшает результат, минимум предобработки текста. Недостатки: большие вычислительные затраты, низкая скорость обработки, нестабильность результата, проблемы с интерпретацией.

Работа с LLM в Loginom — это легко и удобно. Создание запросов к веб-сервисам и обработка ответов не отнимают много времени благодаря подходу low-code.

Необычный кейс — выделение требуемой информации из PDF-отчетов. Задача подобна предыдущей: необходимо идентифицировать объект, описываемый в файле (в данном кейсе — объект недвижимости), и определить его характеристики.

Необычно то, что Loginom, казалось бы, не работает с PDF. В нем есть переменные, таблицы и древовидные структуры для обработки.

Для решения поставленной задачи необходимо прочитать и загрузить один или несколько PDF файлов. Loginom пока этого не умеет. Тут требуется немного кода. Если пользователь этим навыком не обладает — не беда, на выручку придет тот самый ИИ. Он отлично генерирует код на множестве языков программирования.

На выходе компонента импорта получается таблица: каждый PDF-файл имеет свой идентификатор и имя, а каждая его страница загружена как изображение в кодировке BASE64 — это просто набор текстовых символов, соответствующих различным цветам точек изображения.

Теперь можно работать с этой таблицей в Loginom — подготовить запросы к LLM с просьбой решить поставленную задачу. В данном случае подойдут только мультимодальные LLM, которые способны работать с изображениями. Из свободно распространяемых стоит упомянуть gemma3 и qwen3VL.

Удобно использовать OpenRouter.ai — это агрегатор сервисов, обрабатывающих запросы к LLM. Можно выбрать из множества моделей, в том числе бесплатных, если это позволяют политики безопасности.

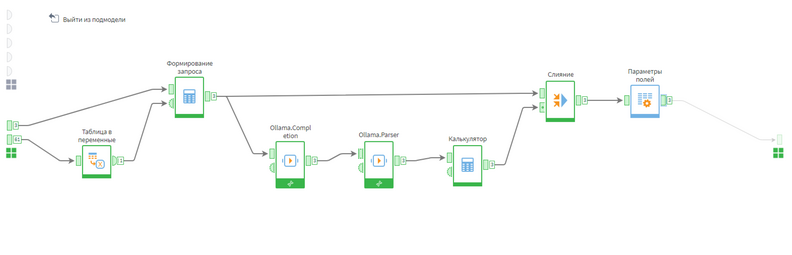

Далее используются два Цикла: один по файлам, другой — по страницам. Обработка одной страницы типовая: собрать данные для запроса (набор атрибутов для определения с описанием особенностей), сформировать запрос под конкретный сервис и использовать компоненты коннектора для его отправки и обработки.

В процессе реализации проекта выбирали из двух подходов:

Остановились на использовании ИИ: во-первых, отдельные модели показали более высокое качество; во-вторых, после LLM получался практически финальный результат, а после OCR нужно долго и кропотливо очищать данные.

Если у Вас есть масса информации в PDF — можно воспользоваться опытом Loginom.

Редкий разработчик любит писать документацию, но без нее нельзя. Обычно в компании выбирают сотрудника, который под конец проекта собирает разрозненные описания в некий приемлемый документ. И помощь тут была бы очень кстати. К счастью, LLM прекрасно с этим справляются.

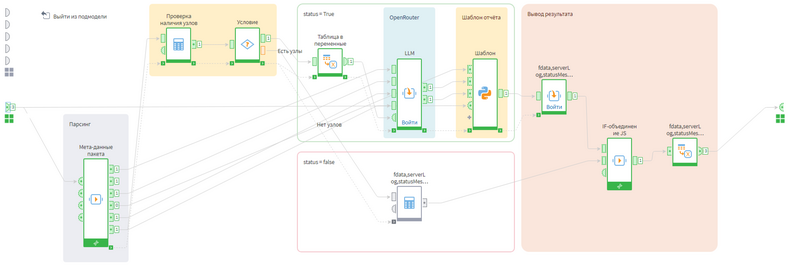

Недавно для Loginom был создан специальный Сценарий, который разбирает и документирует другие Сценарии. Файл, содержащий Сценарий Loginom, — это zip-архив, внутри которого находятся xml-файлы, описывающие используемые компоненты и заданные параметры по каждому Модулю. А xml-файл — это текст, с которым может работать ИИ.

Общий план обработки при автодокументировании

На входе сценария необходимо указать имя файла, который нужно задокументировать. Далее выполняется его парсинг, то есть чтение xml-файлов и создание на их основе определенной структуры, которая будет понятна LLM.

Для получения результата используется несколько запросов к LLM:

Ответы ИИ укладываются в специально подготовленный шаблон документа.

На выходе получается документ с описанием Сценария. Применяя различные шаблоны, можно охватить типовые Сценарии использования: от коротких описаний, до информационно наполненной заготовки документации для дальнейшей редактуры.

Конечно, у этого решения пока есть определенные ограничения, не всегда получается хороший результат. Но в целом понятно, куда двигаться, что, с учетом прогресса самих LLM, вызывает оптимизм в отношении судьбы данного решения. Возможно, достаточно быстро это станет штатным функционалом Loginom.

Не секрет, что LLM уже сейчас неплохо генерируют код. Конечно, в сложных ситуациях, в рамках встраивания кода в большие проекты, они часто выдают ложные результаты. Разработчики многих компаний относятся к этой способности ИИ с недоверием, и это обосновано.

Но небольшие блоки кода для решения конкретных задач по обработке данных они создают весьма хорошо. А это именно то, что требуется пользователю Loginom.

Большую часть работы по анализу данных можно выполнить за счет штатного функционала, не прибегая к программированию. Но порой хочется использовать какую-нибудь модель из богатейшего набора, доступного программирующим на Python. Или нужно сгенерировать набор данных, использовать сложную обработку текста и т.п., для чего весьма уместно будет использовать JavaScript.

Это можно сделать с помощью ChatGPT. Но есть проблема: сгенерированный код будет выполняться в особой среде Loginom, и просто так скопировать его из браузера и выполнить не получится.

Чтобы ИИ сгенерировал код, подходящий для выполнения в Loginom, его нужно ознакомить с соответствующим разделом справочной документации. Это можно сделать, передавая ему ссылки на сайт loginom.ru, или предварительно подготовить на основании документации системный запрос, что и было недавно сделано специалистами Loginom.

Этот файл нужно просто загрузить в чат, описать свою задачу и попросить сгенерировать код для исполнения в Loginom. А дальше — копирование и исполнение.

Это действительно упрощает использование JS и Python в Loginom, и делает его доступным даже для людей незнакомых с программированием. Важно: такой подход хорошо работает только у LLM, способных работать с большим контекстом — GPT5, Gemini 2.5 и т.п. Неплохо себя показала относительно небольшая модель от Nvidia — Nemotron Nano 9B.

Начинать использовать возможности ИИ в Loginom нужно уже сейчас, если у Вас есть подходящие задачи. Но полностью заменить весь Сценарий одним или несколькими вызовами к LLM в ближайшем будущем вряд ли получится. Для получения максимального эффекта следует ориентироваться на преимущества и недостатки, которые отмечены в докладе.

В Loginom уже сформирован релевантный опыт по использованию ИИ. Планируется его учитывать как при развитии самой платформы, так и при реализации проектов клиентов.

Подробнее об использовании ИИ в Loginom можно узнать в выступлении Александра Зацепина, Loginom Company:

pdfРабочие кейсы применения AI с Loginom

Другие материалы по теме:

Конференция «Качество данных 2024»: методы определения рыночной цены